Apple Intelligence est l’épine dorsale de presque toutes les mises à niveau OS 26 cette année. Il alimente la traduction en direct dans les messages et FaceTime, déverrouiller les raccourcis plus intelligents et donner aux développeurs accès à des modèles de langage à grande échelle pour la première fois. Nous obtiendrons également une intelligence visuelle remaniée, plus d’outils Genmoji et un support linguistique élargi.

Mais pour toute son ambition, quelques fonctionnalités majeures sont toujours manquantes, en particulier celle que tout le monde attendait: Siri personnalisé. Confus sur la façon de se sentir? Honnêtement, même. Mais avant de porter un jugement, décomposons ce qui est ici, et ce qui est encore Mia.

Quoi de neuf dans Apple Intelligence pour iOS 26, iPados 26, Visionos et macOS 26

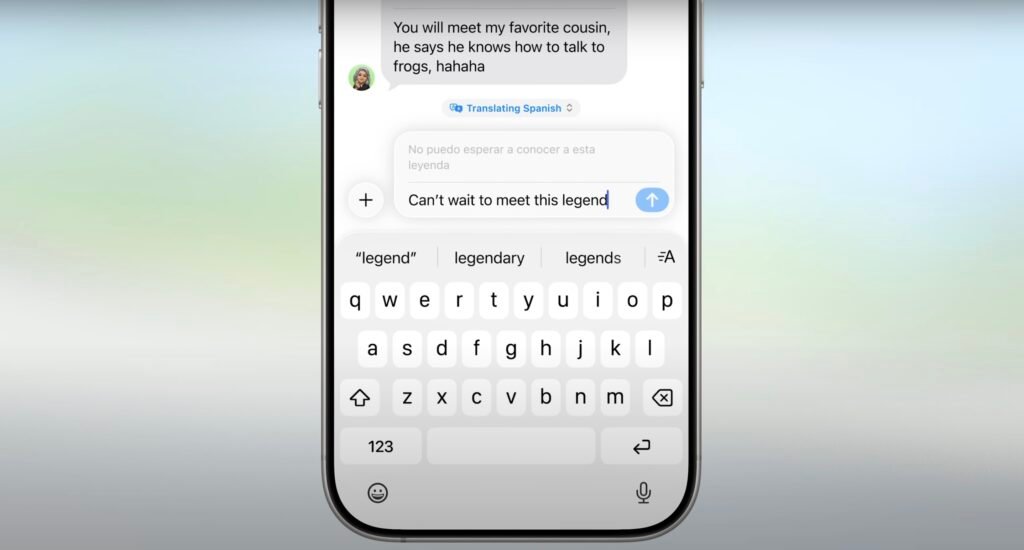

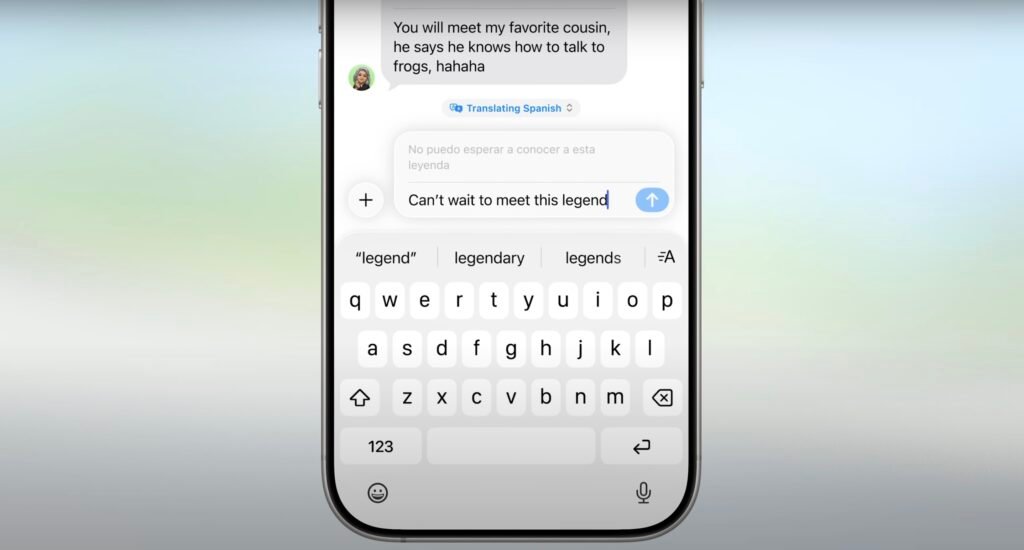

Traduction en direct dans les messages, facetime et le téléphone

La traduction en direct est jusqu’à présent l’utilisation la plus pratique d’Apple sur les dispositions sur les appareils. Il fonctionne en temps réel entre les messages, FaceTime et même l’application de téléphone. Que vous envoyiez un SMS à quelqu’un à l’étranger ou que vous preniez un appel en direct, Apple Intelligence peut traduire du texte et de l’audio sans avoir besoin d’envoyer des données à un serveur.

Tout se passe sur votre appareil en utilisant les propres modèles de langue d’Apple. Cela signifie des temps de réponse plus rapides et une meilleure confidentialité. Aucune donnée ne laisse votre téléphone, ce qui le rend plus sécurisé que de nombreux autres outils de traduction. C’est l’un des exemples les plus clairs de la façon dont Apple utilise l’IA pour faciliter la communication sans compromettre vos informations personnelles.

Intelligence visuelle pour les actions à l’écran

Apple Intelligence comprend maintenant ce qu’il y a sur votre écran, pas seulement ce que vous dites ou tapez. C’est un grand saut pour l’intelligence visuelle, qui se concentrait auparavant sur la reconnaissance des objets et la compréhension de l’image. Maintenant, il peut scanner des captures d’écran, détecter les informations d’événement intégrées ou vous aider à acheter des articles similaires en vous connectant avec Google, Etsy et d’autres applications prises en charge.

Vous pouvez également convoquer directement Chatgpt pour analyser ou expliquer ce qui est à l’écran – il ne faut rien copier et coller quoi que ce soit. Si vous regardez un dépliant avec une date et une heure, votre téléphone pourrait même suggérer de créer un événement de calendrier avec tous les détails remplis.

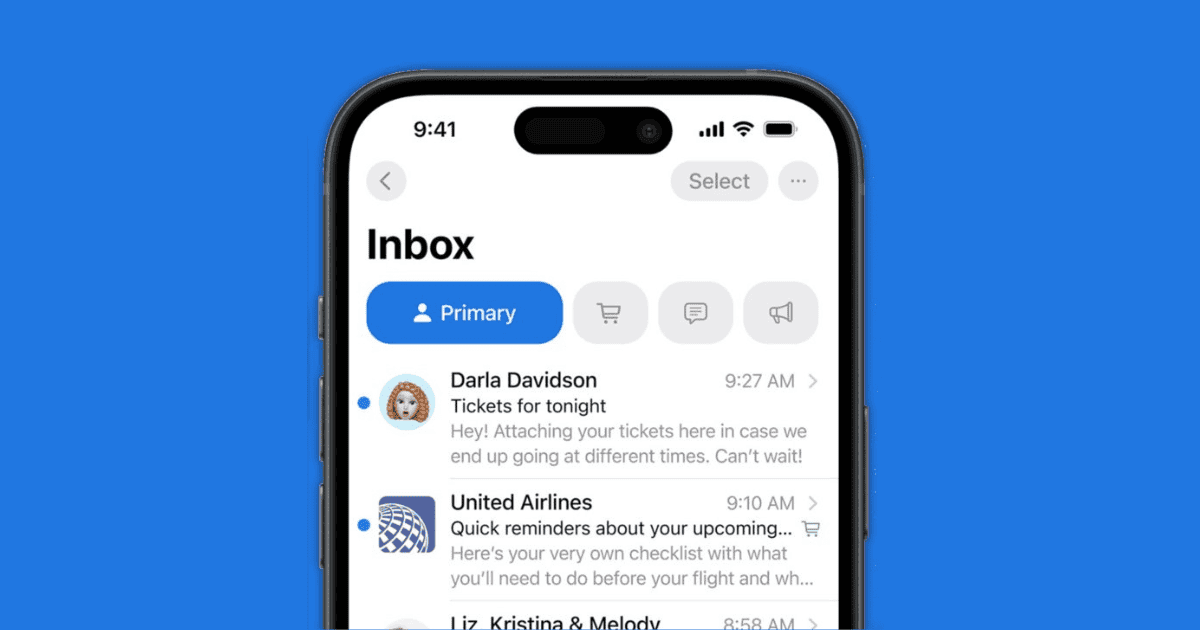

Summaries intelligentes pour le suivi des commandes dans le courrier

Apple Intelligence analyse désormais votre boîte de réception pour les e-mails de confirmation de commande et compile automatiquement les mises à jour de suivi. De plus, ces résumés ne sont pas limités aux transactions Apple Pay. Ils travailleront avec tous les e-mails marchands ou opérateurs, ce qui facilite le maintien de toutes vos livraisons.

Vous trouverez ces résumés de commande unifiés directement dans l’application Mail, aidant à réduire l’encombrement et à gagner du temps. Ce n’est pas flashy, mais c’est utile, surtout si vous en avez assez de sauter entre les e-mails juste pour suivre un package. Le LLM d’Apple gère ceci tranquillement en arrière-plan, rationalisant votre boîte de réception d’une manière qui se sent sans effort.

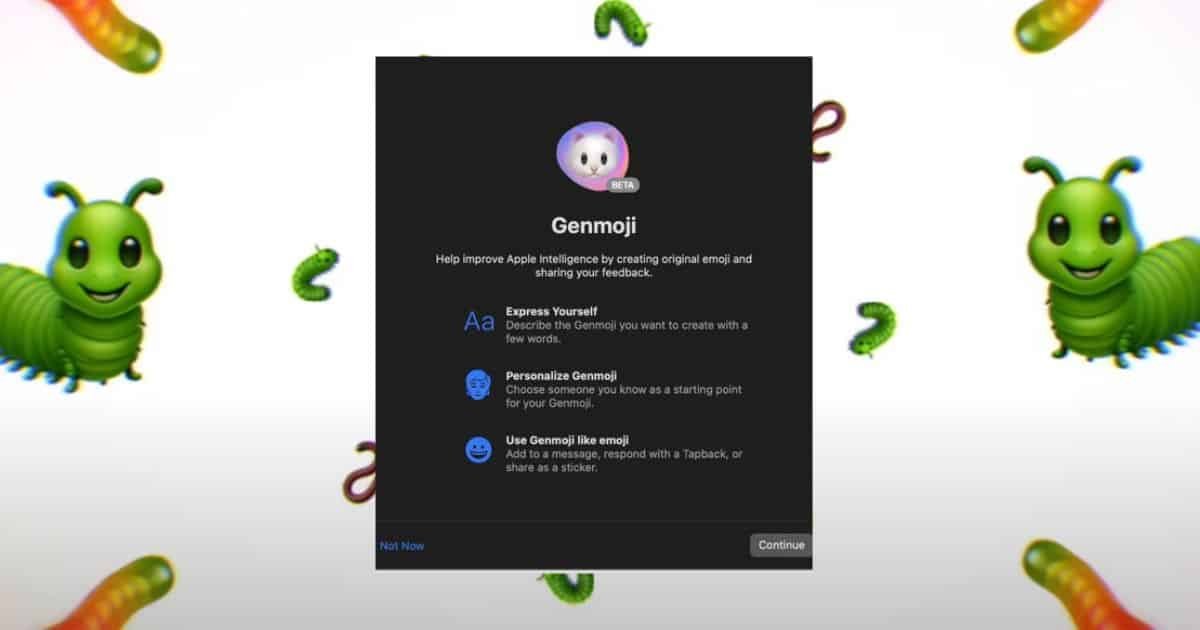

Genmoji et Image Playground

Apple a réintégré la façon dont les utilisateurs créent et utilisent Genmojis. Il vous permet maintenant de combiner les emojis existants, vos propres créations et le texte brut pour générer des visuels personnalisés plus expressifs que jamais. C’est comme donner à vos emoji une personnalité qui lui est propre.

Pendant ce temps, Image Playground vous permet de générer des illustrations complètes à partir de zéro à l’aide d’invites de texte et d’outils créatifs. Tout fonctionne sur le périphérique, et la nouvelle intégration des raccourcis facilite la déclenchement de ces outils sans sauter dans les menus. Bien que cette mise à jour soit principalement pour le plaisir, elle montre comment Apple Intelligence peut alimenter la créativité autant que la productivité.

Raccourcis plus intelligents et plus compétents

Les raccourcis obtiennent une forte augmentation de l’IA dans iOS 26. Apple Intelligence introduit des actions intelligentes qui suggèrent ce que vous pourriez vouloir faire ensuite en fonction du contexte, comme réécrire une note, résumant un message ou lancement d’image de jeux d’image à partir d’une autre application.

Vous verrez également de nouveaux déclencheurs dédiés pour les outils d’écriture, ce qui facilite l’intégration de la relecture ou de la réécriture dans vos workflows existants. Ils sont assez intelligents pour s’adapter à ce que vous faites et suggérer des raccourcis significatifs, ce qui pourrait vous faire gagner du temps dans votre routine quotidienne.

API des modèles de fondation pour les développeurs

Apple ouvre son modèle de grande langue sur l’appareil à des développeurs tiers avec un nouveau cadre de modèles de fondation. Cela signifie que toute application, par exemple, la productivité, la santé et les médias sociaux, peuvent exploiter les capacités d’Apple Intelligence sans compromettre la confidentialité des utilisateurs.

De plus, tout est hors ligne, complètement privé et gratuit. Les paris d’Apple qu’en donnant aux développeurs accès à son moteur d’IA de base, ils lanceront une nouvelle vague d’applications innovantes conçues autour de l’intelligence locale. Si cela fonctionne, iOS pourrait voir une vague d’outils plus intelligents qui ne reposent pas sur les services cloud ou la connectivité constante.

Ce qui manque à Apple Intelligence pour iOS 26, iPados 26, Visionos et macOS 26

La grande mise à niveau de Siri

Parlons de l’éléphant dans la pièce. Comme beaucoup l’ont prédit, nous ne voyons pas le Siri remanié et personnalisé qui a été introduit l’année dernière. Apple Will Déplacez-le probablement en 2026.

Cela signifie que Siri ne pourra pas se rappeler ce que vous avez demandé plus tôt, aider avec les tâches en plusieurs étapes ou répondre en fonction du contexte personnel. Vous obtenez des mises à jour, mais pas le Siri Apple conversationnel et amélioré par la mémoire présenté. Pour l’instant, la version de Siri dans iOS 26 est toujours largement basée sur les règles traditionnelles des assistants vocaux.

Prise en charge limitée de l’appareil

Apple Intelligence est toujours limitée aux modèles iPhone 15 Pro, Pro Max et plus récents. C’est une énorme coupure. Même l’iPhone 15 ordinaire qui a été publié l’année dernière ne se qualifie pas. J’espérais obtenir un meilleur soutien cette année. Si vous possédez quelque chose de plus ancien ou même du modèle de base, vous n’obtiendrez pas du tout une intelligence Apple sur l’apple.

Contexte réel de la plate-plateforme

Apple Intelligence peut identifier les dates ou les événements à l’écran et suggérer de les ajouter au calendrier, mais uniquement si le format est clair et que le contenu est directement reconnu. Si vous copiez un numéro de vol ou une heure manuellement et que vous ouvrez le calendrier, rien ne se passe. Le système ne conserve pas la mémoire de session sur les applications.

C’est une limitation clé. Bien que l’intelligence visuelle puisse scanner ce qui est visible et agir dessus, l’IA d’Apple ne suit pas encore le flux de votre tâche. Il ne se souvient pas de ce que vous avez copié, recherché ou planifié sur les applications à moins qu’il ne correspond à un modèle de reconnaissance étroit. La véritable sensibilisation au contexte croisé est toujours manquante.

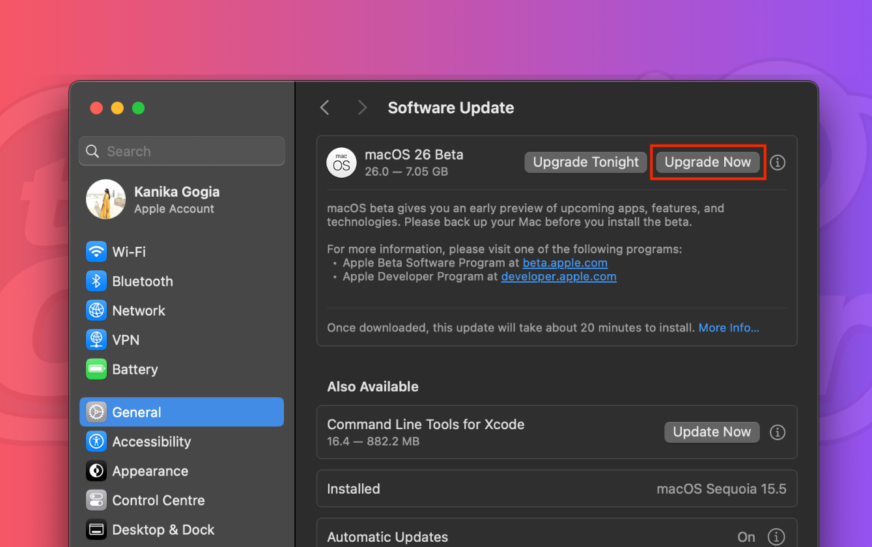

Cela dit, ce ne sont que mes observations. Je suggère de télécharger iOS 26 ou iPados 26 et de les tester vous-même – les versions bêta du développeur sont disponibles en ce moment. Les changements ne sont pas vraiment mauvais, et peut-être que je suis juste pédant. Mais vous devez admettre que de nouvelles fonctionnalités essaient de résoudre des problèmes qui n’existent pas, c’est-à-dire que les modifications de l’interface utilisateur macOS compliquent la navigation.