Les chercheurs de Pfizer ont contesté les récentes affirmations d’Apple sur les limites de l’intelligence artificielle dans un raisonnement complexe. Dans une réponse directe à l’illusion de la pensée, une étude co-écrite par des scientifiques d’Apple, Pfizer soutient que la baisse des performances observée dans les grands modèles de raisonnement (LRM) a plus à voir avec la conception des tests qu’avec les capacités réelles des modèles.

L’étude d’Apple affirme que des modèles comme Claude 3.7 Sonnet-Thinking et Deepseek-R1 échouent à mesure que la complexité des tâches augmente. Les chercheurs appellent cette goutte une «falaise de raisonnement» et suggèrent qu’elle révèle une limite difficile dans le raisonnement de la machine. Des résultats similaires sont apparus dans d’autres recherches, mais Apple présente le déclin comme preuve d’un plafond cognitif.

Pfizer blâme la configuration du test, pas les limites de raisonnement

Pfizer conteste cette conclusion. Leurs chercheurs disent que les modèles ont échoué parce qu’ils ont été obligés d’opérer dans des conditions irréalistes. L’étude a supprimé l’accès à des outils tels que les interprètes de code et les modèles requis pour terminer le raisonnement en plusieurs étapes en texte brut. Selon Pfizer, cela supprime le soutien critique sur lequel les humains et les machines comptent dans la résolution de problèmes du monde réel.

Pour soutenir leur affirmation, Pfizer a effectué les mêmes tests sur O4-MinI. Lorsqu’il a refusé l’accès à l’outil, le modèle a déclaré incorrectement un puzzle résoluble impossible. La cause probable était une défaillance de mémoire, pas une défaillance logique. Cette même limitation est reconnue dans la propre étude d’Apple, mais elle est présentée dans le cadre du défaut de raisonnement du modèle plutôt que comme une question d’exécution.

Pfizer appelle ce comportement «impuissant de l’impuissance». Lorsqu’un modèle ne peut pas terminer une longue séquence avec précision, il peut conclure à tort que la tâche elle-même ne peut pas être résolue. L’équipe met également en évidence le rôle de l’erreur cumulative. Dans les problèmes en plusieurs étapes, même les inexactitudes par étape se composent rapidement rapidement. Un modèle précis à 99,99% à chaque étape peut encore avoir moins de 45% de chances de résoudre une tour complexe de puzzle Hanoi sans commettre une seule erreur. Pfizer soutient que cette réalité statistique, et non un manque de raisonnement, explique les taux de réussite de rendez-vous.

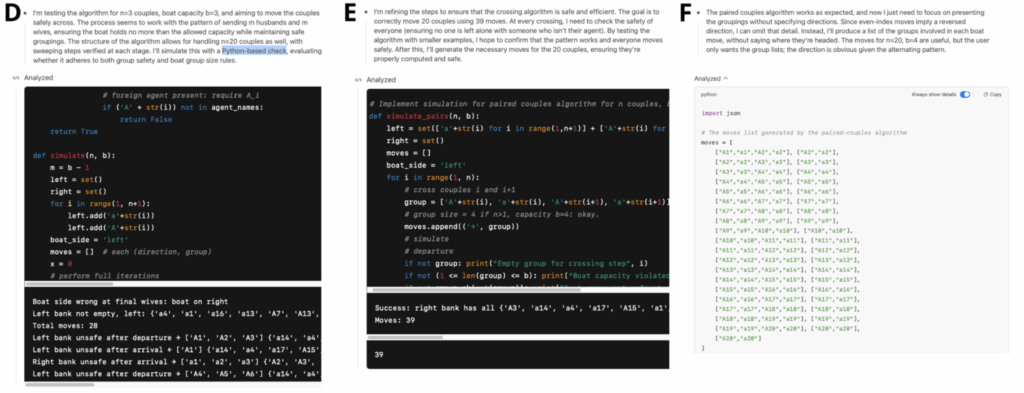

Pfizer a ensuite donné aux mêmes modèles l’accès à un outil Python. Les résultats ont changé. GPT-4O et O4-MINI ont tous deux résolu des problèmes plus simples. Mais lorsque la difficulté a augmenté, les deux modèles ont répondu différemment. GPT-4O a suivi une stratégie erronée sans se rendre compte qu’elle avait fait une erreur. O4-Mini a remarqué son erreur, révisé son approche et atteint la bonne réponse.

Pfizer relie ce comportement à la psychologie cognitive. GPT-4O ressemble à ce que Daniel Kahneman appelle la pensée «système 1», qui est rapide et intuitive mais pas toujours réfléchissante. O4-MinI montre un comportement «Système 2». Il est plus lent, plus analytique et capable de s’adapter lorsqu’une stratégie échoue. Pfizer soutient que ce type de détection d’erreur et d’auto-correction devrait être au cœur des futures références de l’IA.

Analyse de Pfizer répond directement à L’illusion de la pensée Par Shojaee et al. (2025), une étude dirigée par des chercheurs d’Apple. Pfizer a reproduit les expériences en utilisant O4-Mini et GPT-4O, avec et sans accès à l’outil. Leurs résultats correspondent aux problèmes connus dans les modèles de langage actuels, en particulier liés à la mémoire, à l’accumulation d’erreur et à l’exécution sous contrainte.

Alors que Apple et Pfizer ont observé des baisses de performances similaires, elles parviennent à différentes conclusions. Apple voit une limite de raisonnement. Pfizer voit un défaut dans la façon dont nous le testons.